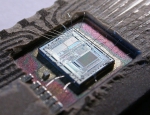

Des travaux concernant une partie encore problématique de l'électrodynamique classique des milieux continus, en l'occurrence des diélectriques, pourraient conduire à la conception d’antennes suffisamment petites pour être installées à l'intérieur de puces électroniques.

Grâce aux découvertes de l’équipe de l’université de Cambridge, il sera peut-être bientôt possible de loger une antenne radio efficace dans une des puces électroniques d'un téléphone.

Grâce aux découvertes de l’équipe de l’université de Cambridge, il sera peut-être bientôt possible de loger une antenne radio efficace dans une des puces électroniques d'un téléphone.

Une équipe de chercheurs de l'université de Cambridge (Royaume-Uni) pense avoir éclairci un vieux problème concernant l'électrodynamique des milieux matériels en physique classique. Leurs travaux, publiés dans la revue Physical Review, portent sur des ondes électromagnétiques générées non seulement par l’accélération des électrons mais aussi par une brisure de la symétrie du champ électrique. Les applications dans le secteur des communications pourraient être nombreuses. Notamment pour le développement de l’Internet des objets, puisque la découverte permet d'envisager la réalisation d'antennes suffisamment petites pour être intégrées dans des puces électroniques. On a bien du mal cependant à prendre au sérieux les affirmations de ces chercheurs exposés dans un communiqué de l'université de Cambridge et dont on ne trouve pas trace dans l'article scientifique. Selon ce communiqué les résultats obtenus pourraient permettre de rapprocher les théories de l'électromagnétisme classique et de la mécanique quantique mais on ne voit pas en quoi, puisque l'électrodynamique quantique est déjà la théorie la plus précise à ce jour et qu'elle est amplement vérifiée par l'expérience.

Rappelons que la fonction d’une antenne est d’émettre et de capter de l’énergie sous la forme d’ondes électromagnétiques. La taille d’une antenne est fonction de la longueur d’onde associée à la fréquence de transmission. Plus exactement, pour qu’une antenne donne son efficacité maximale et que l’énergie transférée soit la plus importante, sa longueur doit être arithmétiquement liée à la fréquence de l'onde. Cependant, même ainsi conçue, plus l’antenne est courte, moins elle est efficace. Il s’agit là de l’un des points bloquants de l’électronique moderne, qui tend inexorablement vers la miniaturisation.

Mais le problème pourrait être résolu grâce à une meilleure compréhension des mécanismes pouvant générer un rayonnement électromagnétique. Une grande part de ce que nous savons à ce sujet nous vient du XIXe siècle et de James Clerk Maxwell : le rayonnement électromagnétique est généré par l'accélération des électrons. Mais, comme le rappelait le grand mathématicien et physicien Henri Poincaré, il n’existe pas problème complètement résolus de sorte qu'il est souvent possible de jeter un nouveau regard sur des théories tout de même bien comprises et bien étudiées. Quelques difficultés sont par exemple repérables dans la théorie classique du rayonnement émis par des diélectriques. Or, justement, certaines antennes, celles de nos téléphones portables, par exemple, sont constituées de résonateurs diélectriques, des isolants dans lesquels, en principe, les électrons ne sont pas libres de se déplacer facilement.

Un champ électromagnétique généré dans un matériau diélectrique

En collaboration avec le Laboratoire national de physique et un fabricant d’antennes diélectriques, la société Antenova, l’équipe de chercheurs de l'université de Cambridge a étudié le comportement de films minces composés de matériaux piézoélectriques (niobate de lithium, nitrure de gallium, arséniure de gallium, etc.). Ce type de matériau présente la propriété de se déformer sous l’action d’un champ électrique. Ils ont découvert qu’à une fréquence déterminée (entre 100 MHz et 3 GHz), ces matériaux deviennent non seulement des résonateurs efficaces mais aussi des émetteurs efficaces et peuvent donc servir d’antennes.

Selon les chercheurs anglais, ce phénomène surprenant serait dû à une brisure de la symétrie du champ électrique. Lorsque les charges électriques sont immobiles, le champ électrique est symétrique. Lorsque les couches minces de matériau piézoélectrique sont soumises à une excitation asymétrique, cette symétrie est brisée et un rayonnement électromagnétique est généré.

Il s'agirait donc d'un nouvelle exemple de l'importance des considérations de symétrie en physique sur lesquelles Pierre Curie, grand contributeur à l'étude des matériaux piézoélectriques, avait déjà attiré l'attention au XIXe siècle en énonçant son célèbre principe de symétrie .

Bonjour l'électromagnétisme pour votre santé! toutes les infos sont sur mon site: