Le champ magnétique de notre planète se manifeste de nombreuses façons et joue un rôle parfois primordial.

Par Sylvain Chevillard.

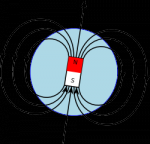

Même si nous n’y prêtons guère attention au quotidien, le champ magnétique de notre planète se manifeste de nombreuses façons et joue un rôle parfois primordial. D’abord, il empêche le vent solaire de chasser notre atmosphère et protège ainsi la vie sur Terre. Il est la source des spectaculaires aurores boréales, visibles dans les pays proches du cercle polaire. Ensuite, certains animaux migrateurs sensibles au champ magnétique l’utilisent pour se repérer, sur le même principe qu’il fait fonctionner les boussoles, longtemps indispensables à la navigation.

Vue schématique du champ magnétique de la Terre.

Mais en dépit de son importance, ce phénomène géophysique pose encore de nombreuses questions. Le champ magnétique provient de ce qu’on appelle la géo-dynamo, à savoir les mouvements turbulents du fer liquide dans le noyau terrestre. Mais on ne sait pas quand et comment ce phénomène a débuté, ni quand et comment il s’arrêtera. Le champ magnétique terrestre s’inverse régulièrement et on ne dispose pas encore d’explications pour ces variations fréquentes dans l’histoire de notre planète. A fortiori, concernant d’autres corps célestes, on en est souvent réduit à faire des hypothèses. Il semblerait que Mars ait possédé une dynamo, mais elle se serait arrêtée et la planète aurait alors perdu son atmosphère. Des observations récentes indiquent que la Lune aurait également possédé une dynamo au début de son existence, mais le mécanisme qui l’alimentait était sans doute différent de celui de la Terre, et reste encore mal compris.

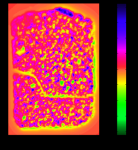

Comment savoir de quoi le passé était fait ? Les roches contiennent des particules ferromagnétiques, qui sont des sortes d’aimants microscopiques. Lorsqu’elle est très chaude la roche devient liquide : pensons par exemple à la lave qui sort d’un volcan. Les particules ferromagnétiques sont alors mobiles et s’orientent dans le sens du champ magnétique ambiant, comme une boussole. En refroidissant, la roche durcit et les particules restent figées dans cette orientation, formant ce qu’on appelle le magnétisme rémanent de la roche. L’observation de ces particules renseigne donc sur l’orientation, mais également sur l’intensité, du champ de l’époque. La mesure des alternances d’orientation du magnétisme rémanent constitue par exemple une des nombreuses méthodes de datation qu’utilisent les géologues. Or, ces micro-aimants émettent eux-mêmes un champ magnétique très faible. Des géophysiciens du MIT aux États-Unis disposent d’un instrument très sensible, appelé microscope SQUID, qui permet d’obtenir une « image » du champ magnétique engendré par un mince échantillon de roche. Chaque point de l’image correspond à la valeur (de la composante verticale) du champ magnétique mesuré en ce point, à une hauteur fixée au-dessus de l’échantillon de roche.

Image du champ magnétique mesuré par le microscope SQUID sur l’échantillon de pierre basaltique hawaïen.

Ici commence le travail du mathématicien : comment remonter de l’image du champ à l’image des particules ferromagnétiques de la roche ? Les équations qui donnent le champ à partir du magnétisme rémanent sont bien connues, mais faire le chemin inverse est compliqué. Il existe en effet des configurations dites silencieuses : les effets des différentes particules s’annulent et finalement, l’échantillon n’émet aucun champ magnétique. Cela entraîne bien des problèmes. Problèmes théoriques d’abord, car cela implique qu’il existe une infinité de magnétismes différents qui produisent exactement le même champ. Comment définir la vraie solution du problème ? Il faut avoir recours à des hypothèses supplémentaires, par exemple supposer que toutes les particules sont orientées parallèlement les unes aux autres. Cette hypothèse est raisonnable pour les roches volcaniques qui n’ont plus jamais été chauffées ni altérées par la suite. Dans ce cas, on s’attend à ce que tous les micro-aimants soient approximativement orientés dans la même direction : celle du champ magnétique de l’époque. Les problèmes sont aussi de nature pratique : comment calculer concrètement la solution ? Les difficultés mathématiques sont rejointes par des considérations numériques : les algorithmes mis au point sont facilement influencés par le bruit des mesures et les erreurs d’arrondi des calculs. Concevoir des méthodes robustes pour résoudre ce problème fait l’objet de recherches actuelles, entre l’équipe APICS de l’INRIA à Sophia-Antipolis, des mathématiciens de Vanderbilt University aux États-Unis et les géophysiciens du MIT, au sein d’un projet appelé IMPINGE.

Pour en savoir plus :

◾Pour La Science n°424 – Février 2013 – Le magnétisme de la Lune, pages 34 à 41.

◾Page Wikipedia sur le champ magnétique terrestre

◾Le site du projet IMPINGE [en anglais].